(Contribution au colloque en l'honneur d'Edmond Malinvaud « Théorie, mesure et expertise » le 9 décembre 2016)

Le directeur général de l'INSEE et le directeur de l'ENSAE, Claude Gruson et Edmond Malinvaud, accueillirent en octobre 1963 une nouvelle promotion d'élèves administrateurs en tenant en substance le discours suivant : « le travail auquel vous allez vous former est obscur et sans gloire, il ne vous donnera que l'austère satisfaction du devoir accompli ». L'un de nous exprima le sentiment commun en s'écriant « qu'est-ce que je fiche donc ici ! ».

Notre génération était l'otage d'une constellation intellectuelle dont les étoiles se nommaient Marxisme, Psychanalyse, Surréalisme, Structuralisme et qui, sous prétexte de libérer les esprits, délimitait étroitement ce qu'il était culturellement légitime de dire et de penser. Les auteurs que nous lisions ignoraient les institutions1 dont le « sérieux » nous inspirait une ironie proche de celle de Boris Vian2.

Quelques-uns d'entre nous ressentaient sans doute peu cette pression, d'autres possédaient dans leur esthétisme le ressort qui les en libérerait, mais dans l'ensemble nous étions comme le sera Michel Foucault3 hostiles envers « les pouvoirs », méfiants envers « le système » et prêts à participer plus tard aux errements de mai 1968. Christian Sautter annoncera ainsi à un magistrat scandalisé que nous refusions de prêter serment : depuis ce jour, les statisticiens français ne sont plus assermentés.

Les cours de l'ENSAE n'étaient pas faits pour nous convenir. Serge Kolm enseignait la théorie néoclassique sans prendre le recul qui aurait permis de concevoir la légitimité de ses hypothèses, Raymond Barre tenait un discours élégant mais vide, Maurice Allais se complaisait dans l'abstraction. Le cours d'économétrie de Malinvaud4 s'appuyait sur les conventions de la comptabilité nationale et nous n'étions pas assez mûrs pour pouvoir apprécier cette structure conceptuelle. Seuls les cours de sociologie de Pierre Bourdieu et Michel Rocard, ainsi que le cours de statistique mathématique de Gérard Calot, m'ont paru alors satisfaisants par leur rigueur et leur qualité pédagogique.

mercredi 30 novembre 2016

mercredi 16 novembre 2016

Les robots et nous

(Article publié le 9 novembre 2016 par Atlantico sous le titre « Serons-nous bientôt capables de créer des robots aussi réalistes que dans Westworld ? ». Les textes de la rédaction sont marqués en gras.)

Les robots nous ressemblent de plus en plus, physiquement et intellectuellement. Quand certains sont enthousiastes vis-à-vis de ces nouvelles technologies, d'autres sont plus méfiants. Dans un futur plus ou moins proche, nous pouvons penser qu'une confusion entre Hommes et robots sera possible.

A l’image de la série Westworld, les industriels essaient de concevoir des robots qui ressemblent de plus en plus à l’Homme physiquement. Quand pourrions-nous voir des robots dont nous pourrions confondre l'apparence avec celle des humains ? Au-delà de la texture de la peau ou du réalisme du regard, à quelles difficultés les ingénieurs sont-ils confrontés ?

Il est facile d'entourer un robot d'une matière qui imite l'apparence d'un être humain. Il est par contre difficile de lui donner un comportement semblable à celui d'un être humain.

C'est possible pour les tâches qu'un programme peut réaliser : puisqu'un programme sait jouer aux échecs, on peut concevoir un robot joueur d'échec qui saurait déplacer les pièces et imiter les mimiques d'un joueur humain.

Le robot est fait pour exécuter un programme, c'est-à-dire accomplir des actions qui ont été prévues par un programmeur. Il fait cela de façon répétitive, mieux, et plus vite que ne le ferait un être humain : c'est la raison pour laquelle on a cru qu'un robot pourrait être "intelligent".

Cependant seul l'être humain est capable d'interpréter une situation nouvelle, de répondre à un événement imprévisible, d'avoir l'intuition qui permet de trouver la réponse à une situation complexe, d'user de discernement face à des cas particuliers surprenants.

Sur le plan de l'intelligence et de la conscience, certaines IA sont-elles aujourd'hui capables de passer le test de Turing ? Quels progrès ont-ils été réalisés ces dernières années, et que reste-t-il toujours à accomplir ?

Non, les IA n'ont pas su passer le test de Turing de façon satisfaisante. Les quelques expériences "réussies" sont tellement artificielles qu'elles ne prouvent rien.

Le vrai problème, celui sur lequel les recherches devraient se concentrer, réside dans la coopération de l'être humain et de l'automate programmable qu'est un robot. Ils ont des capacités et des facultés différentes, qu'il s'agit d'articuler au mieux.

Si l'on croit possible qu'un automate ait la même intelligence qu'un être humain, fût-elle "artificielle", on s'interdit de penser leur articulation, car il est impossible d'articuler l'identique avec soi-même, et du coup on rate le problème le plus intéressant et le plus important.

Au regard des recherches en cours et des problèmes qu'il reste à résoudre, dans combien d'années pourront-nous voir des androïdes tels que ceux de Westworld ?

On peut les voir dès aujourd'hui dans un film ou une série télévisée, où ce sont d'ailleurs des acteurs humains qui jouent le rôle des robots : l'imagination des metteurs en scène n'a pas de limite.

Dans la vraie vie, nous aurons des robots pour les tâches ménagères et dans les entreprises, mais il ne sera pas efficace de leur donner une apparence humaine : un robot aspirateur fonctionne très bien, personne ne pense à lui donner cette apparence.

Je me demande si le rêve d'un robot d'apparence humaine n'exprime pas le désir de voir les êtres humains se comporter comme des robots : c'est déjà le cas des tueurs à gage ou tueurs en série qui occupent tant de place dans les films, ou celui des terroristes robotisés par un lavage de cerveau.

Les régimes totalitaires d'autrefois ont ambitionné de créer un "homme nouveau" qui aurait l'efficacité et l'insensibilité d'une machine mécanique.

La même ambition perverse renaît aujourd'hui, la mécanique étant remplacée par l'informatique.

Les robots nous ressemblent de plus en plus, physiquement et intellectuellement. Quand certains sont enthousiastes vis-à-vis de ces nouvelles technologies, d'autres sont plus méfiants. Dans un futur plus ou moins proche, nous pouvons penser qu'une confusion entre Hommes et robots sera possible.

A l’image de la série Westworld, les industriels essaient de concevoir des robots qui ressemblent de plus en plus à l’Homme physiquement. Quand pourrions-nous voir des robots dont nous pourrions confondre l'apparence avec celle des humains ? Au-delà de la texture de la peau ou du réalisme du regard, à quelles difficultés les ingénieurs sont-ils confrontés ?

Il est facile d'entourer un robot d'une matière qui imite l'apparence d'un être humain. Il est par contre difficile de lui donner un comportement semblable à celui d'un être humain.

C'est possible pour les tâches qu'un programme peut réaliser : puisqu'un programme sait jouer aux échecs, on peut concevoir un robot joueur d'échec qui saurait déplacer les pièces et imiter les mimiques d'un joueur humain.

Le robot est fait pour exécuter un programme, c'est-à-dire accomplir des actions qui ont été prévues par un programmeur. Il fait cela de façon répétitive, mieux, et plus vite que ne le ferait un être humain : c'est la raison pour laquelle on a cru qu'un robot pourrait être "intelligent".

Cependant seul l'être humain est capable d'interpréter une situation nouvelle, de répondre à un événement imprévisible, d'avoir l'intuition qui permet de trouver la réponse à une situation complexe, d'user de discernement face à des cas particuliers surprenants.

Sur le plan de l'intelligence et de la conscience, certaines IA sont-elles aujourd'hui capables de passer le test de Turing ? Quels progrès ont-ils été réalisés ces dernières années, et que reste-t-il toujours à accomplir ?

Non, les IA n'ont pas su passer le test de Turing de façon satisfaisante. Les quelques expériences "réussies" sont tellement artificielles qu'elles ne prouvent rien.

Le vrai problème, celui sur lequel les recherches devraient se concentrer, réside dans la coopération de l'être humain et de l'automate programmable qu'est un robot. Ils ont des capacités et des facultés différentes, qu'il s'agit d'articuler au mieux.

Si l'on croit possible qu'un automate ait la même intelligence qu'un être humain, fût-elle "artificielle", on s'interdit de penser leur articulation, car il est impossible d'articuler l'identique avec soi-même, et du coup on rate le problème le plus intéressant et le plus important.

Au regard des recherches en cours et des problèmes qu'il reste à résoudre, dans combien d'années pourront-nous voir des androïdes tels que ceux de Westworld ?

On peut les voir dès aujourd'hui dans un film ou une série télévisée, où ce sont d'ailleurs des acteurs humains qui jouent le rôle des robots : l'imagination des metteurs en scène n'a pas de limite.

Dans la vraie vie, nous aurons des robots pour les tâches ménagères et dans les entreprises, mais il ne sera pas efficace de leur donner une apparence humaine : un robot aspirateur fonctionne très bien, personne ne pense à lui donner cette apparence.

Je me demande si le rêve d'un robot d'apparence humaine n'exprime pas le désir de voir les êtres humains se comporter comme des robots : c'est déjà le cas des tueurs à gage ou tueurs en série qui occupent tant de place dans les films, ou celui des terroristes robotisés par un lavage de cerveau.

Les régimes totalitaires d'autrefois ont ambitionné de créer un "homme nouveau" qui aurait l'efficacité et l'insensibilité d'une machine mécanique.

La même ambition perverse renaît aujourd'hui, la mécanique étant remplacée par l'informatique.

lundi 14 novembre 2016

Qu'est-ce que l'iconomie ?

(Article publié sur le site iconomie.org)

L’étymologie du mot « iconomie » associe les deux mots grecs « eikon » (image) et « nomos » (organisation). Cette construction est semblable à celle d’ « économie » qui associe « oikos » (maison, famille) à « nomos » : l’économie, c’est la gestion d’une famille1.

L’économiste brésilien Gilson Schwartz2 estime que « dans l’iconomie le nomos est défini par l’icône, par quelque chose d’intangible, qui est un code visuel, immatériel, réel et symbolique en même temps : cette iconomie, qui transforme notre mode de penser, mesurer et sentir, ressemble à un jeu ».

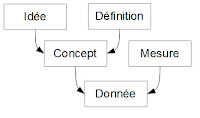

Pour sa part l’institut de l’iconomie définit ainsi l’iconomie : « Société dont l’économie, les institutions et les modes de vie s’appuient sur la synergie de la microélectronique, du logiciel et de l’Internet3 ». Il a construit le modèle schématique d’une telle société, par hypothèse efficace.

L’iconomie ainsi conçue n’est pas une prévision mais un repère posé à l’horizon du futur pour indiquer une orientation aux stratèges, hommes d’État et entrepreneurs, ainsi qu’aux animateurs qui agissent dans les institutions, en mettant en évidence les possibilités et les risques qu’apporte l’informatisation4.

Ce repère invite à combler l’écart qui existe entre la société actuelle, qui subit une crise de transition, et une efficacité économique potentielle évaluée selon le bien-être matériel de la population.

Il est vrai que l’informatisation entoure le monde réel d’une doublure symbolique qui le reproduit dans le monde de la pensée sous forme d’images : il en résulte des effets psychologiques et sociologiques aussi intenses que ceux qu’ont eus en leur temps l’écriture et l’imprimerie. C’est sur ces effets que Gilson Schwartz a focalisé son attention.

Le modèle de l’iconomie, tel que l’institut de l’iconomie l’a élaboré, les prend en considération pour faire apparaître les conditions nécessaires de l’efficacité dans le système technique contemporain5.

__________________

1 On dit « économie politique » pour désigner la gestion d’une nation, « polis » (la cité).

2 Gilson Schwartz, « Iconomie, diversité culturelle et monétisation ludique sur l’internet des objets », in Lilian Richieri-Hanania et Anne-Thida Norodom, Diversité des expressions culturelles à l’ère du numérique, Teseo, 2016.

3 Michel Volle, iconomie, Economica, 2014, p. 11.

4 Certains préfèrent dire « numérique » ou « digital » plutôt qu’« informatique », et orientent leur intuition dans la perspective d’une « intelligence artificielle » et de robots humanoïdes.

5 La notion de « système technique » est due à Bertrand Gille, Histoire des techniques, Gallimard, La Pléiade, 1978.

L’étymologie du mot « iconomie » associe les deux mots grecs « eikon » (image) et « nomos » (organisation). Cette construction est semblable à celle d’ « économie » qui associe « oikos » (maison, famille) à « nomos » : l’économie, c’est la gestion d’une famille1.

L’économiste brésilien Gilson Schwartz2 estime que « dans l’iconomie le nomos est défini par l’icône, par quelque chose d’intangible, qui est un code visuel, immatériel, réel et symbolique en même temps : cette iconomie, qui transforme notre mode de penser, mesurer et sentir, ressemble à un jeu ».

Pour sa part l’institut de l’iconomie définit ainsi l’iconomie : « Société dont l’économie, les institutions et les modes de vie s’appuient sur la synergie de la microélectronique, du logiciel et de l’Internet3 ». Il a construit le modèle schématique d’une telle société, par hypothèse efficace.

L’iconomie ainsi conçue n’est pas une prévision mais un repère posé à l’horizon du futur pour indiquer une orientation aux stratèges, hommes d’État et entrepreneurs, ainsi qu’aux animateurs qui agissent dans les institutions, en mettant en évidence les possibilités et les risques qu’apporte l’informatisation4.

Ce repère invite à combler l’écart qui existe entre la société actuelle, qui subit une crise de transition, et une efficacité économique potentielle évaluée selon le bien-être matériel de la population.

Il est vrai que l’informatisation entoure le monde réel d’une doublure symbolique qui le reproduit dans le monde de la pensée sous forme d’images : il en résulte des effets psychologiques et sociologiques aussi intenses que ceux qu’ont eus en leur temps l’écriture et l’imprimerie. C’est sur ces effets que Gilson Schwartz a focalisé son attention.

Le modèle de l’iconomie, tel que l’institut de l’iconomie l’a élaboré, les prend en considération pour faire apparaître les conditions nécessaires de l’efficacité dans le système technique contemporain5.

__________________

1 On dit « économie politique » pour désigner la gestion d’une nation, « polis » (la cité).

2 Gilson Schwartz, « Iconomie, diversité culturelle et monétisation ludique sur l’internet des objets », in Lilian Richieri-Hanania et Anne-Thida Norodom, Diversité des expressions culturelles à l’ère du numérique, Teseo, 2016.

3 Michel Volle, iconomie, Economica, 2014, p. 11.

4 Certains préfèrent dire « numérique » ou « digital » plutôt qu’« informatique », et orientent leur intuition dans la perspective d’une « intelligence artificielle » et de robots humanoïdes.

5 La notion de « système technique » est due à Bertrand Gille, Histoire des techniques, Gallimard, La Pléiade, 1978.

lundi 24 octobre 2016

Les économistes et la statistique

Le statisticien qui débarque parmi les économistes découvre avec surprise comment la plupart d'entre eux utilisent la statistique (nous parlons ici du comportement massif de cette corporation, non des grands économistes qui sont des utilisateurs prudents).

Les malentendus abondent. Le lien de la statistique avec l'Etat, « Staat », lui a conféré un caractère officiel (elle alimente les offices de l'administration) qui n'a aucun rapport avec l'exigence scientifique.

Malinvaud a cru pouvoir exprimer celle-ci en disant que le statisticien devait être objectif, expression ambiguë qui peut signifier que le statisticien doit être honnête, ce qui devrait aller sans dire, mais aussi que la statistique doit reproduire fidèlement et entièrement l'objet qu'elle observe, ce qui est hors de sa portée.

Du point de vue scientifique le critère de la qualité de la statistique est la pertinence qui implique une subjectivité non pas individuelle, mais historique et collective : elle doit répondre à la situation particulière d'une société.

Ce point de vue est rarement présent dans les faits. Pour la machine administrative toute interrogation sur la qualité de la « statistique officielle » est un sacrilège ou, à tout le moins, une impertinence. L'éthique professionnelle de la plupart des statisticiens est par ailleurs celle de l'objectivité : ils ne truqueront jamais les produits de l'usine qu'ils font fonctionner, mais ils se soucient peu des ressorts de son évolution.

Celle-ci est lente car il faut au moins une dizaine d'années pour que l'observation d'un phénomène nouveau puisse fournir des résultats utilisables : c'est le délai nécessaire pour définir les concepts, tester la faisabilité d'une enquête, l'exploiter, publier ses résultats, disposer enfin d'une série chronologique assez longue pour amorcer son interprétation. La recherche de la productivité exigeant la stabilité des méthodes, elles tendent à se figer en habitudes et traditions.

Les malentendus abondent. Le lien de la statistique avec l'Etat, « Staat », lui a conféré un caractère officiel (elle alimente les offices de l'administration) qui n'a aucun rapport avec l'exigence scientifique.

Malinvaud a cru pouvoir exprimer celle-ci en disant que le statisticien devait être objectif, expression ambiguë qui peut signifier que le statisticien doit être honnête, ce qui devrait aller sans dire, mais aussi que la statistique doit reproduire fidèlement et entièrement l'objet qu'elle observe, ce qui est hors de sa portée.

Du point de vue scientifique le critère de la qualité de la statistique est la pertinence qui implique une subjectivité non pas individuelle, mais historique et collective : elle doit répondre à la situation particulière d'une société.

Ce point de vue est rarement présent dans les faits. Pour la machine administrative toute interrogation sur la qualité de la « statistique officielle » est un sacrilège ou, à tout le moins, une impertinence. L'éthique professionnelle de la plupart des statisticiens est par ailleurs celle de l'objectivité : ils ne truqueront jamais les produits de l'usine qu'ils font fonctionner, mais ils se soucient peu des ressorts de son évolution.

Celle-ci est lente car il faut au moins une dizaine d'années pour que l'observation d'un phénomène nouveau puisse fournir des résultats utilisables : c'est le délai nécessaire pour définir les concepts, tester la faisabilité d'une enquête, l'exploiter, publier ses résultats, disposer enfin d'une série chronologique assez longue pour amorcer son interprétation. La recherche de la productivité exigeant la stabilité des méthodes, elles tendent à se figer en habitudes et traditions.

L'économie est ni plus ni moins hypothétique que les autres sciences

La science économique (economics) ambitionne de rendre compte du fonctionnement de l'économie réelle (economy), monde de la production, des échanges et de la consommation. Ce monde étant complexe, la pensée ne peut le représenter que sous la forme de schémas simples que l'on nomme « modèles ».

Il en est de même, notons-le, pour tous les « mondes » que la pensée explore (celui de la nature physique, celui de la biologie, etc.) : elle est toujours simple en regard de leur complexité. Un schéma peut cependant, comme le fait une caricature, dégager les traits essentiels de l'objet considéré et servir ainsi de tremplin à l'intellect1.

Chaque économie est caractérisée par les ressources disponibles, les capacités du système productif et les besoins des consommateurs (les économistes disent « dotation initiale, fonction de production, fonction d'utilité »). Le modèle d'une économie particulière consiste en hypothèses concernant ces caractéristiques, et en un raisonnement qui en déduit les conséquences.

La science économique est donc essentiellement hypothétique : la qualité des leçons que fournit le raisonnement dépend de la pertinence des hypothèses en regard d'une situation que l'on souhaite interpréter puis comprendre.

Lorsqu'un économiste suppose que l'information des agents économiques (entreprises, consommateurs) est parfaite, il n'affirme pas qu'il en est ainsi dans la réalité : il ne fait qu'explorer, en simulant mentalement son fonctionnement, le monde où cette hypothèse serait vérifiée.

Pour se préparer à construire des modèles pertinents en regard de situations particulières, l'économiste fait des exercices de gymnastique intellectuelle : il explore mentalement des mondes divers, bâtis à partir d'hypothèses elles-mêmes diverses dont il s'exerce à tirer les conséquences, et cela le prépare à concevoir les mécanismes essentiels d'une économie, à interpréter sa situation et, finalement, à voir clairement ce que doivent faire une entreprise, une banque centrale, un gouvernement.

Il en est de même, notons-le, pour tous les « mondes » que la pensée explore (celui de la nature physique, celui de la biologie, etc.) : elle est toujours simple en regard de leur complexité. Un schéma peut cependant, comme le fait une caricature, dégager les traits essentiels de l'objet considéré et servir ainsi de tremplin à l'intellect1.

Chaque économie est caractérisée par les ressources disponibles, les capacités du système productif et les besoins des consommateurs (les économistes disent « dotation initiale, fonction de production, fonction d'utilité »). Le modèle d'une économie particulière consiste en hypothèses concernant ces caractéristiques, et en un raisonnement qui en déduit les conséquences.

La science économique est donc essentiellement hypothétique : la qualité des leçons que fournit le raisonnement dépend de la pertinence des hypothèses en regard d'une situation que l'on souhaite interpréter puis comprendre.

Lorsqu'un économiste suppose que l'information des agents économiques (entreprises, consommateurs) est parfaite, il n'affirme pas qu'il en est ainsi dans la réalité : il ne fait qu'explorer, en simulant mentalement son fonctionnement, le monde où cette hypothèse serait vérifiée.

Pour se préparer à construire des modèles pertinents en regard de situations particulières, l'économiste fait des exercices de gymnastique intellectuelle : il explore mentalement des mondes divers, bâtis à partir d'hypothèses elles-mêmes diverses dont il s'exerce à tirer les conséquences, et cela le prépare à concevoir les mécanismes essentiels d'une économie, à interpréter sa situation et, finalement, à voir clairement ce que doivent faire une entreprise, une banque centrale, un gouvernement.

vendredi 21 octobre 2016

De la statistique à l'économie

Je comprends ceux qui disent que l'économie n'est pas une science : j'ai longtemps partagé cette opinion. J'ai détesté l'économie lorsque j'étais en 1963 étudiant à l'ENSAE, école qui formait les futurs administrateurs de l'INSEE.

Le cours de théorie économique de Serge Kolm était dogmatique et peu convaincant. Raymond Barre tenait un discours élégant et creux. Le cours d'économétrie d'Edmond Malinvaud s'enfermait dans les conventions de la comptabilité nationale et dans les subtilités de la régression multiple.

Tout cela formait un ensemble qui manquait de cohésion. Je soupçonnais cette « science » de n'être qu'un plaidoyer, masqué par une mathématisation superficielle, en faveur d'une conception de la société à laquelle je n'avais aucune envie d'adhérer.

J'ai donc décidé de me consacrer à la statistique, au constat des faits, qui me semblait pouvoir aider la personne immature que j'étais à comprendre le monde qui l'entourait.

J'ai conçu, réalisé et publié des enquêtes statistiques. Dans le contexte de l'INSEE d'alors c'était un travail de soutier car le prestige allait aux comptables nationaux, aux économètres qui produisaient des modèles et, plus encore, aux économistes théoriciens qui publiaient dans des revues à comité de lecture des articles remplis d'équations. J'étais fier d'être de ceux qui maniaient le charbon à la pelle.

J'ai cependant découvert dans la statistique des choses qui m'ont préoccupé. Comme tout instrument d'observation elle doit choisir dans la complexité du monde les objets sur lesquels elle va se focaliser. Elle va donc observer des choses jugées importantes. Mais quel est le critère qui permet d'évaluer cette importance ? Quels sont les raisonnements que cette évaluation suppose ? Ils étaient extérieurs à la statistique, qu'ils conditionnaient : elle ne pouvait donc pas être un monde intellectuel se suffisant à lui-même.

Le statisticien doit faire encore d'autres choix. Lorsqu'il cherche à classer les individus selon les professions et catégories socio-professionnelles, il doit définir une nomenclature qui comportera une liste de postes élémentaires, classés selon des rubriques agrégées. Dans la statistique des entreprises, qui était devenue ma spécialité, il fallait des nomenclatures de produits et d'activité économique et les mêmes questions se posaient : comment choisir les postes élémentaires, selon quel critère les rassembler en agrégats ?

Le cours de théorie économique de Serge Kolm était dogmatique et peu convaincant. Raymond Barre tenait un discours élégant et creux. Le cours d'économétrie d'Edmond Malinvaud s'enfermait dans les conventions de la comptabilité nationale et dans les subtilités de la régression multiple.

Tout cela formait un ensemble qui manquait de cohésion. Je soupçonnais cette « science » de n'être qu'un plaidoyer, masqué par une mathématisation superficielle, en faveur d'une conception de la société à laquelle je n'avais aucune envie d'adhérer.

J'ai donc décidé de me consacrer à la statistique, au constat des faits, qui me semblait pouvoir aider la personne immature que j'étais à comprendre le monde qui l'entourait.

J'ai conçu, réalisé et publié des enquêtes statistiques. Dans le contexte de l'INSEE d'alors c'était un travail de soutier car le prestige allait aux comptables nationaux, aux économètres qui produisaient des modèles et, plus encore, aux économistes théoriciens qui publiaient dans des revues à comité de lecture des articles remplis d'équations. J'étais fier d'être de ceux qui maniaient le charbon à la pelle.

J'ai cependant découvert dans la statistique des choses qui m'ont préoccupé. Comme tout instrument d'observation elle doit choisir dans la complexité du monde les objets sur lesquels elle va se focaliser. Elle va donc observer des choses jugées importantes. Mais quel est le critère qui permet d'évaluer cette importance ? Quels sont les raisonnements que cette évaluation suppose ? Ils étaient extérieurs à la statistique, qu'ils conditionnaient : elle ne pouvait donc pas être un monde intellectuel se suffisant à lui-même.

Le statisticien doit faire encore d'autres choix. Lorsqu'il cherche à classer les individus selon les professions et catégories socio-professionnelles, il doit définir une nomenclature qui comportera une liste de postes élémentaires, classés selon des rubriques agrégées. Dans la statistique des entreprises, qui était devenue ma spécialité, il fallait des nomenclatures de produits et d'activité économique et les mêmes questions se posaient : comment choisir les postes élémentaires, selon quel critère les rassembler en agrégats ?

lundi 17 octobre 2016

L'intérêt général confronté à la transition numérique

(Contribution à un ouvrage prochainement publié par le cercle Turgot sous la direction de Claude Revel)

Résumé

Le « numérique » est le nom qui a été donné à l'informatisation de la société dans les années 2010. Il est caractérisé par l'automatisation des tâches répétitives dont résulte une transformation de la nature des produits, des processus de production, du travail, du régime de concurrence et de la mission du régulateur, ainsi qu'une montée de la délinquance financière. L'intérêt général exige de soutenir les entrepreneurs et de réprimer les prédateurs.

"Digital" is the name that was given in the 2010s to the computerization of society. It is basically characterized by the automation of repetitive tasks, which led to fundamental changes in the nature of products, in the production processes, in the employment and in the competition regime, as well as to a rise in financial crime.As a result, the mission of the regulator is more than ever to ensure a fair and durable development, and particularly in that context to support entrepreneurs and to punish predators.

Le numérique transforme la nature à laquelle sont confrontées les intentions et les actions humaines : l'Internet a supprimé nombre des effets de la distance géographique et l'ensemble des ordinateurs en réseau constitue un gigantesque automate programmable, logiciels et documents étant accessibles à l'utilisateur via l'interface que procurent un poste de travail, une tablette, un téléphone mobile.

Dans les entreprises l'acteur est le couple que forment l'individu et cet automate, l'être humain augmenté. L'automate a vocation à accomplir les tâches répétitives physiques ou mentales : dans les usines des robots remplacent la main d'oeuvre à qui l'on demandait naguère de répéter un geste de façon réflexe, des logiciels accélèrent le travail des biologistes et des juristes, des simulateurs facilitent celui des architectes et des ingénieurs1.

La transformation du travail

Restent à l'être humain ce qui ne peut pas être programmé : la création d'idées et de produits nouveaux, la relation avec d'autres êtres humains. La main d'oeuvre fait ainsi place dans l'emploi à un cerveau d'oeuvre, la force de travail change de nature.

Nombre d'emplois disparaissent tandis qu'émerge un besoin de compétences nouvelles. La crise de transition qui en résulte est analogue à celle qu'a provoquée la mécanisation qui a, au début du XIXe siècle, frappé d'obsolescence les méthodes artisanales de filature et de tissage. Le plein emploi de la force de travail n'est pas impossible mais il exige une redéfinition des compétences.

Le numérique transforme en effet les produits : un constructeur automobile, par exemple, ne produit plus des voitures mais l'assemblage formé par la voiture et les services qui permettent de l'utiliser : location ou financement d'un prêt, entretien, réparations, assurance, etc. De façon générale chaque produit est désormais un assemblage de biens et de services dont un système d'information assure la cohésion.

La production de cet assemblage est le fait d'un réseau de partenaires dont la coopération et l'interopérabilité sont assurées là encore par un système d'information : le numérique est devenu le pivot stratégique de l'entreprise.

La conception d'un produit est aussi l'ingénierie de sa production (définition et programmation des automates, organisation des services, montage du partenariat) : cet investissement, qui exige l'« esprit de géométrie » dont a parlé Pascal, s'accumule sous la forme d'un stock de « travail à effet différé », d'un capital.

Les services que le produit comporte exigent la compétence relationnelle, la capacité de répondre à des imprévus et d'interpréter des cas particuliers, l'« esprit de finesse » qui s'exprime dans un « travail à effet immédiat ». Telles sont les deux formes de travail qui s'offrent au cerveau d'oeuvre.

Un nouveau régime du marché

L'essentiel du coût de production est dépensé lors de l'investissement initial, avant la vente du premier exemplaire du produit et avant la perception des initiatives de la concurrence : l'économie informatisée est l'économie du risque maximum. Le partage de la production avec un réseau de partenaires permet de le contenir.

Résumé

Le « numérique » est le nom qui a été donné à l'informatisation de la société dans les années 2010. Il est caractérisé par l'automatisation des tâches répétitives dont résulte une transformation de la nature des produits, des processus de production, du travail, du régime de concurrence et de la mission du régulateur, ainsi qu'une montée de la délinquance financière. L'intérêt général exige de soutenir les entrepreneurs et de réprimer les prédateurs.

"Digital" is the name that was given in the 2010s to the computerization of society. It is basically characterized by the automation of repetitive tasks, which led to fundamental changes in the nature of products, in the production processes, in the employment and in the competition regime, as well as to a rise in financial crime.As a result, the mission of the regulator is more than ever to ensure a fair and durable development, and particularly in that context to support entrepreneurs and to punish predators.

* *

Le numérique transforme la nature à laquelle sont confrontées les intentions et les actions humaines : l'Internet a supprimé nombre des effets de la distance géographique et l'ensemble des ordinateurs en réseau constitue un gigantesque automate programmable, logiciels et documents étant accessibles à l'utilisateur via l'interface que procurent un poste de travail, une tablette, un téléphone mobile.

Dans les entreprises l'acteur est le couple que forment l'individu et cet automate, l'être humain augmenté. L'automate a vocation à accomplir les tâches répétitives physiques ou mentales : dans les usines des robots remplacent la main d'oeuvre à qui l'on demandait naguère de répéter un geste de façon réflexe, des logiciels accélèrent le travail des biologistes et des juristes, des simulateurs facilitent celui des architectes et des ingénieurs1.

La transformation du travail

Restent à l'être humain ce qui ne peut pas être programmé : la création d'idées et de produits nouveaux, la relation avec d'autres êtres humains. La main d'oeuvre fait ainsi place dans l'emploi à un cerveau d'oeuvre, la force de travail change de nature.

Nombre d'emplois disparaissent tandis qu'émerge un besoin de compétences nouvelles. La crise de transition qui en résulte est analogue à celle qu'a provoquée la mécanisation qui a, au début du XIXe siècle, frappé d'obsolescence les méthodes artisanales de filature et de tissage. Le plein emploi de la force de travail n'est pas impossible mais il exige une redéfinition des compétences.

Le numérique transforme en effet les produits : un constructeur automobile, par exemple, ne produit plus des voitures mais l'assemblage formé par la voiture et les services qui permettent de l'utiliser : location ou financement d'un prêt, entretien, réparations, assurance, etc. De façon générale chaque produit est désormais un assemblage de biens et de services dont un système d'information assure la cohésion.

La production de cet assemblage est le fait d'un réseau de partenaires dont la coopération et l'interopérabilité sont assurées là encore par un système d'information : le numérique est devenu le pivot stratégique de l'entreprise.

La conception d'un produit est aussi l'ingénierie de sa production (définition et programmation des automates, organisation des services, montage du partenariat) : cet investissement, qui exige l'« esprit de géométrie » dont a parlé Pascal, s'accumule sous la forme d'un stock de « travail à effet différé », d'un capital.

Les services que le produit comporte exigent la compétence relationnelle, la capacité de répondre à des imprévus et d'interpréter des cas particuliers, l'« esprit de finesse » qui s'exprime dans un « travail à effet immédiat ». Telles sont les deux formes de travail qui s'offrent au cerveau d'oeuvre.

Un nouveau régime du marché

L'essentiel du coût de production est dépensé lors de l'investissement initial, avant la vente du premier exemplaire du produit et avant la perception des initiatives de la concurrence : l'économie informatisée est l'économie du risque maximum. Le partage de la production avec un réseau de partenaires permet de le contenir.

jeudi 29 septembre 2016

Notre Trump

Jean-Paul Betbèze a publié un excellent billet : Donald Trump : « Moi Président, grâce à la post-vérité ! ».

La post-vérité consiste à s'appuyer non sur le constat des faits, mais sur des préjugés et sur les intérêts particuliers qu'ils reflètent : l'orateur tend à son public un miroir dans lequel celui-ci se reconnaît avec ravissement (Robert Escarpit a décrit cela dans Le ministricule).

Rencontrant ainsi des agriculteurs au Salon de l’Agriculture en 2010, Nicolas Sarkozy leur a dit : « Toutes ces questions d’environnement, ça commence à bien faire ! ». Ils ont exulté.

« Ça commence à bien faire » est une expression révélatrice. Il ne s'agit pas de savoir si l'écologie est importante ou non, mais de savoir si l'on a ou non envie de zapper. Ce n'est pas la réalité qui importe, mais l'image qui s'en forme dans un cerveau versatile.

Sarkozy a récemment ajouté : « Cela fait quatre milliards d’années que le climat change. Le Sahara est devenu un désert, ce n’est pas à cause de l’industrie. Il faut être arrogant comme l’Homme pour penser que c’est nous qui avons changé le climat ». Il se range donc parmi ceux qui, comme Claude Allègre, nient l'origine humaine du réchauffement climatique.

J'ai participé voici quelques années à un déjeuner avec Sarkozy organisé par L'Expansion. Il était alors ministre de l'intérieur. Quelqu'un lui a demandé s'il pensait « que la France aurait bientôt pour président un fils d'immigré » (sic). Il a répondu : « Il ne faut pas se cacher derrière son petit doigt : la seule chose qui compte, en politique, c'est de gagner les élections ». Et les convives de rire, complices...

La post-vérité est l'outil de la victoire électorale. Cet outil se paie par la versatilité et l'incohérence du propos, car d'un auditoire à l'autre les opinions changent, mais qu'importe si l'on récolte à chaque fois des applaudissements !

Il se peut que le praticien de la post-vérité, se prenant au jeu, estime que plus rien n'existe en dehors du miroir que sa parole tend à l'opinion : « la réalité, cela n'existe pas », dira-t-il alors.

Chacun gère sa propre santé mentale : celle d'un Trump ou d'un Sarkozy, c'est leur affaire. Celle de la population est plus préoccupante.

On croyait au XIXe siècle qu'il suffirait de généraliser l'accès aux études pour que la démocratie s'épanouisse : cela n'a pas empêché l'Allemagne de céder dans les années 1930 aux séductions que l'on sait, alors qu'elle était un des pays les plus éduqués.

Le démagogue séduit, l'irresponsable plaît. Si notre population adhère à ce point à leur discours, c'est sans doute aussi parce que l'establishment obéit à des rites qui simulent le sérieux : il porte donc une part de responsabilité dans le succès des farceurs.

Considérons la science. Le critère du sérieux, dit-on, c'est de publier dans des revues à comité de lecture. « Publish or perish » : ceux qui n'adhèrent pas à ce rite sont inaudibles. Et voilà que l'on croule sous le nombre d'articles fallacieux, que les affaires de trucage s'accumulent...

Il y a quelque chose de pourri dans le royaume du conformisme.

La post-vérité consiste à s'appuyer non sur le constat des faits, mais sur des préjugés et sur les intérêts particuliers qu'ils reflètent : l'orateur tend à son public un miroir dans lequel celui-ci se reconnaît avec ravissement (Robert Escarpit a décrit cela dans Le ministricule).

Rencontrant ainsi des agriculteurs au Salon de l’Agriculture en 2010, Nicolas Sarkozy leur a dit : « Toutes ces questions d’environnement, ça commence à bien faire ! ». Ils ont exulté.

« Ça commence à bien faire » est une expression révélatrice. Il ne s'agit pas de savoir si l'écologie est importante ou non, mais de savoir si l'on a ou non envie de zapper. Ce n'est pas la réalité qui importe, mais l'image qui s'en forme dans un cerveau versatile.

Sarkozy a récemment ajouté : « Cela fait quatre milliards d’années que le climat change. Le Sahara est devenu un désert, ce n’est pas à cause de l’industrie. Il faut être arrogant comme l’Homme pour penser que c’est nous qui avons changé le climat ». Il se range donc parmi ceux qui, comme Claude Allègre, nient l'origine humaine du réchauffement climatique.

J'ai participé voici quelques années à un déjeuner avec Sarkozy organisé par L'Expansion. Il était alors ministre de l'intérieur. Quelqu'un lui a demandé s'il pensait « que la France aurait bientôt pour président un fils d'immigré » (sic). Il a répondu : « Il ne faut pas se cacher derrière son petit doigt : la seule chose qui compte, en politique, c'est de gagner les élections ». Et les convives de rire, complices...

* *

La post-vérité est l'outil de la victoire électorale. Cet outil se paie par la versatilité et l'incohérence du propos, car d'un auditoire à l'autre les opinions changent, mais qu'importe si l'on récolte à chaque fois des applaudissements !

Il se peut que le praticien de la post-vérité, se prenant au jeu, estime que plus rien n'existe en dehors du miroir que sa parole tend à l'opinion : « la réalité, cela n'existe pas », dira-t-il alors.

Chacun gère sa propre santé mentale : celle d'un Trump ou d'un Sarkozy, c'est leur affaire. Celle de la population est plus préoccupante.

On croyait au XIXe siècle qu'il suffirait de généraliser l'accès aux études pour que la démocratie s'épanouisse : cela n'a pas empêché l'Allemagne de céder dans les années 1930 aux séductions que l'on sait, alors qu'elle était un des pays les plus éduqués.

Le démagogue séduit, l'irresponsable plaît. Si notre population adhère à ce point à leur discours, c'est sans doute aussi parce que l'establishment obéit à des rites qui simulent le sérieux : il porte donc une part de responsabilité dans le succès des farceurs.

Considérons la science. Le critère du sérieux, dit-on, c'est de publier dans des revues à comité de lecture. « Publish or perish » : ceux qui n'adhèrent pas à ce rite sont inaudibles. Et voilà que l'on croule sous le nombre d'articles fallacieux, que les affaires de trucage s'accumulent...

Il y a quelque chose de pourri dans le royaume du conformisme.

samedi 23 juillet 2016

Il faut défendre les institutions

Plus on crie à l'horreur après les attentats, plus on se livre à des « hommages aux victimes », plus on suscite le terrorisme auquel on prétend faire la guerre.

Il ne manquera jamais en effet d'esprits faibles pour qui l'apothéose meurtrière et suicidaire peut apparaître comme le moyen d'exister enfin, d'avoir son nom imprimé dans les journaux, sa personne analysée dans les médias.

Celui qui se « radicalise » fait peur comme le faisait naguère un SS. Il se sent important aux yeux des autres et, surtout, à ses propres yeux. La religion n'est alors qu'un prétexte : le dernier de ces crétins, celui de Nice, n'avait paraît-il jamais mis les pieds dans une mosquée.

La cible des terroristes, ce ne sont pas les victimes qu'ils font au hasard, c'est le patrimoine des institutions dont l'histoire a doté notre pays.

La police et les services de renseignements vont bloquer certaines tentatives mais ils ne pourront pas les bloquer toutes. Il se produira donc d'autres attentats – il s'en produira d'autant plus que nous aurons, par notre comportement, suscité davantage de vocations parmi les imbéciles.

Il ne manquera jamais en effet d'esprits faibles pour qui l'apothéose meurtrière et suicidaire peut apparaître comme le moyen d'exister enfin, d'avoir son nom imprimé dans les journaux, sa personne analysée dans les médias.

Celui qui se « radicalise » fait peur comme le faisait naguère un SS. Il se sent important aux yeux des autres et, surtout, à ses propres yeux. La religion n'est alors qu'un prétexte : le dernier de ces crétins, celui de Nice, n'avait paraît-il jamais mis les pieds dans une mosquée.

La cible des terroristes, ce ne sont pas les victimes qu'ils font au hasard, c'est le patrimoine des institutions dont l'histoire a doté notre pays.

La police et les services de renseignements vont bloquer certaines tentatives mais ils ne pourront pas les bloquer toutes. Il se produira donc d'autres attentats – il s'en produira d'autant plus que nous aurons, par notre comportement, suscité davantage de vocations parmi les imbéciles.

lundi 18 juillet 2016

L'écart entre logiciel et logique

J'ai longtemps cru que le logiciel était logique, car il appartient au monde de la pensée alors que la matière dont sont faits les processeurs, mémoires et réseaux est soumise aux aléas du monde de la nature (transformation de la structure cristalline, effets du rayonnement cosmique, etc.).

Mais les logiciels qu'une DSI achète à des fournisseurs (systèmes d'exploitation, « progiciels », ERP, CRM, etc.) sont-ils vraiment des êtres logiques ?

La plupart sont un assemblage de composants « boîte noire » dont on ne connaît que les interfaces d'entrée et de sortie (les « API ») et que l'on aura collés ensemble avec une « glu » de code.

Si le logiciel est un produit de la pensée, il s'agit d'une pensée en cascade dont la compréhension ne se transmet pas d'un étage à l'autre : cela le rend aussi complexe qu'un être naturel ou matériel.

Mais les logiciels qu'une DSI achète à des fournisseurs (systèmes d'exploitation, « progiciels », ERP, CRM, etc.) sont-ils vraiment des êtres logiques ?

La plupart sont un assemblage de composants « boîte noire » dont on ne connaît que les interfaces d'entrée et de sortie (les « API ») et que l'on aura collés ensemble avec une « glu » de code.

Si le logiciel est un produit de la pensée, il s'agit d'une pensée en cascade dont la compréhension ne se transmet pas d'un étage à l'autre : cela le rend aussi complexe qu'un être naturel ou matériel.

jeudi 14 juillet 2016

À l'horizon : une histoire courte

Anne Papillault et Jean-François Dars publient sur le Web des Histoires courtes, courts romans-photos de la recherche.

La soixante-dix-septième Histoire courte ("À l’horizon") vient d'être mise en ligne. Elle est consacrée à l'iconomie.

Le lien vers toutes les histoires courtes est http://llx.fr, le lien vers celle-ci est ici : À l’horizon.

Pour respecter le format d'une Histoire courte Dars et Papillault ont dû réduire le texte. Vous trouverez ci-dessous le texte complet.

La soixante-dix-septième Histoire courte ("À l’horizon") vient d'être mise en ligne. Elle est consacrée à l'iconomie.

Le lien vers toutes les histoires courtes est http://llx.fr, le lien vers celle-ci est ici : À l’horizon.

Pour respecter le format d'une Histoire courte Dars et Papillault ont dû réduire le texte. Vous trouverez ci-dessous le texte complet.

samedi 18 juin 2016

Jean Tirole, Économie du bien commun, PUF, 2016

Le livre passionnant de Jean Tirole s'appuie sur trois principes qu'il énonce clairement et dont il tire les conséquences en les appliquant à des domaines divers : le fonctionnement des marchés, la gouvernance des entreprises, le défi climatique, le chômage, l'Europe, la finance, la politique industrielle, l'économie numérique, l'innovation et la régulation.

La diversité de ces domaines illustre la fécondité de ces principes, qui se condensent dans les expressions suivantes : partir de faits stylisés ; considérer les asymétries d'information ; tenir compte des incitations.

Franck Aggeri a publié une critique approfondie des travaux de Tirole dans « Les phénomènes gestionnaires à l'épreuve de la pensée économique standard », Revue française de gestion, n° 250, 2015. Cette critique, intéressante, a cependant raté ce qui me semble être, chez Tirole, une grave lacune.

La diversité de ces domaines illustre la fécondité de ces principes, qui se condensent dans les expressions suivantes : partir de faits stylisés ; considérer les asymétries d'information ; tenir compte des incitations.

Franck Aggeri a publié une critique approfondie des travaux de Tirole dans « Les phénomènes gestionnaires à l'épreuve de la pensée économique standard », Revue française de gestion, n° 250, 2015. Cette critique, intéressante, a cependant raté ce qui me semble être, chez Tirole, une grave lacune.

mercredi 1 juin 2016

Valeurs de la transition numérique

Je viens de terminer la rédaction de Valeurs de la transition numérique, dont le sous-titre est « Civilisation de la troisième révolution industrielle ».

Ce livre se trouvant à l'intersection de la philosophie, de l'histoire et de l'économie, seuls pourront le goûter ceux des lecteurs qui tolèrent une démarche pluri-disciplinaire.

Vous pouvez pour le lire le télécharger au format pdf (1, 73 Mo) en cliquant ici.

Voici la table des matières :

I PROLOGUE

1 La crise du numérique

1.1 Crise des valeurs

1.2 L'époque du numérique

1.3 L'iconomie comme orientation

Ce livre se trouvant à l'intersection de la philosophie, de l'histoire et de l'économie, seuls pourront le goûter ceux des lecteurs qui tolèrent une démarche pluri-disciplinaire.

Vous pouvez pour le lire le télécharger au format pdf (1, 73 Mo) en cliquant ici.

Voici la table des matières :

I PROLOGUE

1 La crise du numérique

1.1 Crise des valeurs

1.2 L'époque du numérique

1.3 L'iconomie comme orientation

dimanche 24 avril 2016

Le secret des animateurs

L'animateur, c'est celui qui « donne une âme » à une entreprise, et plus généralement à une institution, qui « fait tourner la boutique » en réglant sans faire d'histoire les incidents quotidiens, qui crée une « bonne ambiance », etc. Il n'a évidemment rien à voir avec l'animateur des plateaux de télé, qui n'est qu'un séducteur divertissant : c'est une secrétaire ici, un directeur là, une infirmière à l'hôpital, un facteur à la campagne, un professeur, un secrétaire général, un artisan, un commerçant, etc.

On rencontre des animateurs dans toutes les catégories de la population active. Ils sont discrets, car ils ne sont pas de ces arrivistes qui cherchent à « faire carrière ». Il faut donc être attentif pour les repérer, les identifier et les dénombrer. Leur proportion varie selon l'institution considérée et selon l'époque, la moyenne se trouvant aux alentours de 10 % selon les experts avec qui j'ai pu me concerter.

La plupart des personnes ne perçoivent pas les qualités de l'animateur et ne lui savent aucun gré de ce qu'il apporte. Celles qui les perçoivent admirent sa générosité, son équilibre, sa patience, et le trouvent sympathique.

On peut donc être tenté de voir en lui un être essentiellement moral, une personne de bonne volonté. Cependant la proportion des animateurs varie, d'une institution à l'autre, plus qu'on ne l'attend de celle des individus « moraux ». Les qualités qui rendent une personne sympathique s'estompent d'ailleurs dans les animateurs que l'on trouve parmi les dirigeants : les entrepreneurs et les hommes d'Etat.

Parmi les dirigeants de l'économie et de la politique, rares sont ceux qui méritent d'être considérés comme des entrepreneurs et des hommes d'Etat : la proportion est là encore de l'ordre de 10 %. Ces animateurs-là ne se contentent pas d'occuper une position d'autorité : ils orientent l'institution, la nation, en trouvant parmi les obstacles et les ressources le point sur lequel ils peuvent appuyer le levier d'une action stratégique. Il faut pour cela qu'ils s'émancipent de la sociologie de leur milieu pour concentrer leur attention sur la physique et la logique de l'action.

Ces entrepreneurs, ces hommes d'Etat, sont des passionnés souvent autoritaires : Henry Ford, Louis Renault, Steve Jobs, Marcel Dassault, Charles de Gaulle ont certes « donné une âme » à leur entreprise ou à la nation, ils ont été des animateurs, mais même si on les admire leur caractère n'inspire pas la sympathie.

Un salarié ne peut pas être un animateur sans présenter des qualités « morales », car la sympathie qu'il inspire est une condition nécessaire de son efficacité. Elle n'est pas nécessaire au même point chez l'entrepreneur et l'homme d'Etat car la rudesse, voire la brutalité du comportement sont tolérées et même attendues chez un dirigeant.

Il faut donc chercher ailleurs le secret de l'animateur. Il ne lui est certes pas interdit d'être généreux, équilibré et patient même quand il est un dirigeant – la générosité du créateur peut se concilier avec de la rudesse – mais ce n'est pas dans ces qualités que réside le ressort de l'animation.

Où se trouve-t-il ? Qu'est-ce qui distingue le 10 % des animateurs du 90 % des autres personnes ?

On rencontre des animateurs dans toutes les catégories de la population active. Ils sont discrets, car ils ne sont pas de ces arrivistes qui cherchent à « faire carrière ». Il faut donc être attentif pour les repérer, les identifier et les dénombrer. Leur proportion varie selon l'institution considérée et selon l'époque, la moyenne se trouvant aux alentours de 10 % selon les experts avec qui j'ai pu me concerter.

La plupart des personnes ne perçoivent pas les qualités de l'animateur et ne lui savent aucun gré de ce qu'il apporte. Celles qui les perçoivent admirent sa générosité, son équilibre, sa patience, et le trouvent sympathique.

On peut donc être tenté de voir en lui un être essentiellement moral, une personne de bonne volonté. Cependant la proportion des animateurs varie, d'une institution à l'autre, plus qu'on ne l'attend de celle des individus « moraux ». Les qualités qui rendent une personne sympathique s'estompent d'ailleurs dans les animateurs que l'on trouve parmi les dirigeants : les entrepreneurs et les hommes d'Etat.

Parmi les dirigeants de l'économie et de la politique, rares sont ceux qui méritent d'être considérés comme des entrepreneurs et des hommes d'Etat : la proportion est là encore de l'ordre de 10 %. Ces animateurs-là ne se contentent pas d'occuper une position d'autorité : ils orientent l'institution, la nation, en trouvant parmi les obstacles et les ressources le point sur lequel ils peuvent appuyer le levier d'une action stratégique. Il faut pour cela qu'ils s'émancipent de la sociologie de leur milieu pour concentrer leur attention sur la physique et la logique de l'action.

Ces entrepreneurs, ces hommes d'Etat, sont des passionnés souvent autoritaires : Henry Ford, Louis Renault, Steve Jobs, Marcel Dassault, Charles de Gaulle ont certes « donné une âme » à leur entreprise ou à la nation, ils ont été des animateurs, mais même si on les admire leur caractère n'inspire pas la sympathie.

Un salarié ne peut pas être un animateur sans présenter des qualités « morales », car la sympathie qu'il inspire est une condition nécessaire de son efficacité. Elle n'est pas nécessaire au même point chez l'entrepreneur et l'homme d'Etat car la rudesse, voire la brutalité du comportement sont tolérées et même attendues chez un dirigeant.

Il faut donc chercher ailleurs le secret de l'animateur. Il ne lui est certes pas interdit d'être généreux, équilibré et patient même quand il est un dirigeant – la générosité du créateur peut se concilier avec de la rudesse – mais ce n'est pas dans ces qualités que réside le ressort de l'animation.

Où se trouve-t-il ? Qu'est-ce qui distingue le 10 % des animateurs du 90 % des autres personnes ?

jeudi 21 avril 2016

Lire les maths

Dans le monde de la pensée chaque partie est aussi complexe que le tout : ce monde est analogue à l'espace, où un segment de droite contient autant de points que l'univers entier. Le « petit monde » qu'explore un chercheur se déploie ainsi en une richesse sans limite.

Les mathématiques explorent divers « petits mondes » : l'espace euclidien, les espaces de Riemann, les nombres entiers, les probabilités, etc. Des passerelles existent et certains d'entre eux peuvent s'agréger en un plus grand « petit monde », mais chacun répond à une intuition particulière et son exploration requiert une démarche qui lui est propre.

Le calcul des probabilités développe ainsi une tournure d'esprit qui ouvre à la pensée une avenue inédite : l'intuition probabiliste, n'étant pas innée, est absente chez nombre de personnes.

Deux attitudes s'opposent de façon polaire dans la relation que l'on peut avoir avec les maths : l'une, formaliste, convient aux personnes qui ont l'esprit clair et une bonne mémoire. J'ai eu ainsi à l'Ecole polytechnique des camarades auxquels les maths ne présentaient aucune difficulté : pour pouvoir assimiler un de leurs « petits mondes », il leur suffisait de vérifier la cohérence des hypothèses et l'exactitude du raisonnement.

D'autres ont avec les maths un rapport plus difficile car ils se posent deux questions auxquelles le cours ne répond pratiquement jamais : « pourquoi » et « comment ». Pourquoi a-t-on choisi telles hypothèses ? Comment s'y est-on pris pour bâtir les inférences et les démonstrations ?

Ces questions ne sont pas les bienvenues. Un de mes amis, rencontrant au lycée des intégrales pour la première fois, demanda au professeur à quoi elles pouvaient servir. Il pensait à leur apport au développement logique des maths mais le professeur crut qu'il voulait savoir si elles pourraient l'aider à « gagner sa vie » : il se fit réprimander.

Le formaliste, qui ne cherche pas « midi à quatorze heures », n'est jamais tracassé par une inquiétude. Tout est évident devant son regard limpide et si l'assimilation du cours lui demande un travail celui-ci, réduit à une vérification technique, n'implique ni passion, ni souci, ni interrogation. Il est un bon élève tandis que celui que tracassent le « pourquoi » et le « comment » s'embarrasse de préoccupations qui sont inutiles lorsque le but est d'« avoir de bonnes notes », d'« avoir son bac », de « réussir aux concours », etc.

Quelle est donc, se demande en effet ce dernier, l'intention qui a conduit Galois à considérer les groupes de commutations ? Quelles sont celles qui ont poussé Newton vers le calcul différentiel, incité Gauss à explorer les congruences, Lagrange à chercher les équations de la mécanique, Cantor à considérer des ensembles infinis ? Comment chacun s'y est-il pris ensuite pour explorer le « petit monde » qui s'ouvrait devant lui ?

Il se peut que ce mauvais élève à l'esprit récalcitrant soit mieux préparé que ne l'est le formaliste au jour où il faudra dépasser l'apprentissage pour aborder la recherche, car comme il s'est familiarisé avec ce qui se passe dans la tête d'un chercheur il s'est rapproché de l'esprit de la recherche.

Les mathématiques explorent divers « petits mondes » : l'espace euclidien, les espaces de Riemann, les nombres entiers, les probabilités, etc. Des passerelles existent et certains d'entre eux peuvent s'agréger en un plus grand « petit monde », mais chacun répond à une intuition particulière et son exploration requiert une démarche qui lui est propre.

Le calcul des probabilités développe ainsi une tournure d'esprit qui ouvre à la pensée une avenue inédite : l'intuition probabiliste, n'étant pas innée, est absente chez nombre de personnes.

* *

Deux attitudes s'opposent de façon polaire dans la relation que l'on peut avoir avec les maths : l'une, formaliste, convient aux personnes qui ont l'esprit clair et une bonne mémoire. J'ai eu ainsi à l'Ecole polytechnique des camarades auxquels les maths ne présentaient aucune difficulté : pour pouvoir assimiler un de leurs « petits mondes », il leur suffisait de vérifier la cohérence des hypothèses et l'exactitude du raisonnement.

D'autres ont avec les maths un rapport plus difficile car ils se posent deux questions auxquelles le cours ne répond pratiquement jamais : « pourquoi » et « comment ». Pourquoi a-t-on choisi telles hypothèses ? Comment s'y est-on pris pour bâtir les inférences et les démonstrations ?

Ces questions ne sont pas les bienvenues. Un de mes amis, rencontrant au lycée des intégrales pour la première fois, demanda au professeur à quoi elles pouvaient servir. Il pensait à leur apport au développement logique des maths mais le professeur crut qu'il voulait savoir si elles pourraient l'aider à « gagner sa vie » : il se fit réprimander.

* *

Le formaliste, qui ne cherche pas « midi à quatorze heures », n'est jamais tracassé par une inquiétude. Tout est évident devant son regard limpide et si l'assimilation du cours lui demande un travail celui-ci, réduit à une vérification technique, n'implique ni passion, ni souci, ni interrogation. Il est un bon élève tandis que celui que tracassent le « pourquoi » et le « comment » s'embarrasse de préoccupations qui sont inutiles lorsque le but est d'« avoir de bonnes notes », d'« avoir son bac », de « réussir aux concours », etc.

Quelle est donc, se demande en effet ce dernier, l'intention qui a conduit Galois à considérer les groupes de commutations ? Quelles sont celles qui ont poussé Newton vers le calcul différentiel, incité Gauss à explorer les congruences, Lagrange à chercher les équations de la mécanique, Cantor à considérer des ensembles infinis ? Comment chacun s'y est-il pris ensuite pour explorer le « petit monde » qui s'ouvrait devant lui ?

Il se peut que ce mauvais élève à l'esprit récalcitrant soit mieux préparé que ne l'est le formaliste au jour où il faudra dépasser l'apprentissage pour aborder la recherche, car comme il s'est familiarisé avec ce qui se passe dans la tête d'un chercheur il s'est rapproché de l'esprit de la recherche.

mercredi 6 avril 2016

Pour comprendre les "Panama Papers"

Derrière le phénomène des « Panama Papers » se trouvent une économie et une sociologie.

L'économie en question est celle de la prédation que j'ai décrite dans Prédation et prédateurs (Economica, janvier 2008). Pour rendre compte de l'économie actuelle, penser l'équilibre des échanges ne suffit pas : il faut penser aussi la prédation, qui consiste à prendre quelque chose sans rien donner en échange. Elle a pris une importance telle qu'on ne peut plus la négliger.

La sociologie est celle d'une résurgence des privilèges et du parasitisme de la noblesse de l'ancien régime.

Les plus riches estiment en effet avoir droit au privilège légal de ne pas payer l'impôt, qui était avant la Révolution celui de la noblesse, et ils l'obtiennent par l'optimisation fiscale. Les conseils des avocats et des banques étant onéreux, ce privilège est réservé à ceux qui peuvent les payer. La charge de l'impôt sera alors entièrement portée par le tiers état de la classe moyenne, dont les revenus et le bien-être sont par ailleurs comprimés par la crise économique. Cette situation est potentiellement explosive.

De l'optimisation fiscale « légale » à la fraude fiscale, il n'y a psychologiquement qu'un pas que certains franchissent. La Banque y trouve son compte car ses services sont rémunérés et elle prélève un pourcentage sur les montants concernés.

Des chefs d'entreprise se voient ainsi proposer par un conseiller financier des montages qui combinent l'abus de biens sociaux, la fraude fiscale et le blanchiment : « vous seriez bien bête de ne pas en profiter comme tout le monde », s'entendent-ils dire. Seuls les plus vertueux peuvent résister à une telle tentation.

Ainsi la ploutocratie (pouvoir des plus riches) se développe en aristocratie (pouvoir des meilleurs), non sans les ridicules du Bourgeois gentilhomme car la distinction ne s'acquiert qu'en plusieurs générations, et encore pas toujours.

Les procédés sont grossiers : on est « résident en Suisse » (ou au Luxembourg, en Belgique, etc.) ; on a « enregistré son entreprise au Delaware » ; on échange de bons tuyaux entre riches lors des dîners en ville : comment délocaliser les emplois dans des pays à bas salaire, comment comprimer les effectifs de son entreprise. Ayant le plaisir de se sentir entre soi, on rit alors de bon cœur.

L'économie en question est celle de la prédation que j'ai décrite dans Prédation et prédateurs (Economica, janvier 2008). Pour rendre compte de l'économie actuelle, penser l'équilibre des échanges ne suffit pas : il faut penser aussi la prédation, qui consiste à prendre quelque chose sans rien donner en échange. Elle a pris une importance telle qu'on ne peut plus la négliger.

La sociologie est celle d'une résurgence des privilèges et du parasitisme de la noblesse de l'ancien régime.

Les plus riches estiment en effet avoir droit au privilège légal de ne pas payer l'impôt, qui était avant la Révolution celui de la noblesse, et ils l'obtiennent par l'optimisation fiscale. Les conseils des avocats et des banques étant onéreux, ce privilège est réservé à ceux qui peuvent les payer. La charge de l'impôt sera alors entièrement portée par le tiers état de la classe moyenne, dont les revenus et le bien-être sont par ailleurs comprimés par la crise économique. Cette situation est potentiellement explosive.

De l'optimisation fiscale « légale » à la fraude fiscale, il n'y a psychologiquement qu'un pas que certains franchissent. La Banque y trouve son compte car ses services sont rémunérés et elle prélève un pourcentage sur les montants concernés.

Des chefs d'entreprise se voient ainsi proposer par un conseiller financier des montages qui combinent l'abus de biens sociaux, la fraude fiscale et le blanchiment : « vous seriez bien bête de ne pas en profiter comme tout le monde », s'entendent-ils dire. Seuls les plus vertueux peuvent résister à une telle tentation.

Ainsi la ploutocratie (pouvoir des plus riches) se développe en aristocratie (pouvoir des meilleurs), non sans les ridicules du Bourgeois gentilhomme car la distinction ne s'acquiert qu'en plusieurs générations, et encore pas toujours.

Les procédés sont grossiers : on est « résident en Suisse » (ou au Luxembourg, en Belgique, etc.) ; on a « enregistré son entreprise au Delaware » ; on échange de bons tuyaux entre riches lors des dîners en ville : comment délocaliser les emplois dans des pays à bas salaire, comment comprimer les effectifs de son entreprise. Ayant le plaisir de se sentir entre soi, on rit alors de bon cœur.

dimanche 3 avril 2016

Histoire de l'iconomie (suite)

(Ce texte fait suite à Histoire de l'iconomie)

Nous sommes depuis 2010 à l'époque du numérique. C'est un des épisodes de l'informatisation, déploiement historique et progressif du potentiel que comporte l'alliage du cerveau humain et de l'automate programmable.

Mais qu'entend-on par « numérique » ? Certains pensent que ce mot signifie que « tout est nombre », comme disait Pythagore, car dans un ordinateur tout programme et tout document (texte, image, son, etc.) sont représentés chacun par un nombre binaire.

D'autres disent que le numérique est né lorsque le téléphone mobile est devenu un ordinateur mobile : ils l'assimilent ainsi à l'ubiquité de la ressource informatique. D'autres encore pensent que ce qui le caractérise, c'est d'offrir à chacun la possibilité de contribuer à une production culturelle qui se trouve ainsi démultipliée. D'autres enfin estiment que l'époque du numérique est celle où l'innovation dans les usages est devenue plus importante que l'innovation dans les techniques, etc.

« Numérique » prend ainsi des sens très divers dans des expressions comme « culture numérique », « révolution numérique », « aménagement numérique », « empreinte numérique », « humanités numériques », « entreprise numérique », « démocratie numérique », etc. Cette polysémie a l'avantage de rassembler sous un même mot des phénomènes qui, tous, se manifestent en effet actuellement : cela facilite la conversation dans notre époque confuse, mais au risque d'accroître sa confusion en disséminant des malentendus.

Nous sommes depuis 2010 à l'époque du numérique. C'est un des épisodes de l'informatisation, déploiement historique et progressif du potentiel que comporte l'alliage du cerveau humain et de l'automate programmable.

Mais qu'entend-on par « numérique » ? Certains pensent que ce mot signifie que « tout est nombre », comme disait Pythagore, car dans un ordinateur tout programme et tout document (texte, image, son, etc.) sont représentés chacun par un nombre binaire.

D'autres disent que le numérique est né lorsque le téléphone mobile est devenu un ordinateur mobile : ils l'assimilent ainsi à l'ubiquité de la ressource informatique. D'autres encore pensent que ce qui le caractérise, c'est d'offrir à chacun la possibilité de contribuer à une production culturelle qui se trouve ainsi démultipliée. D'autres enfin estiment que l'époque du numérique est celle où l'innovation dans les usages est devenue plus importante que l'innovation dans les techniques, etc.

« Numérique » prend ainsi des sens très divers dans des expressions comme « culture numérique », « révolution numérique », « aménagement numérique », « empreinte numérique », « humanités numériques », « entreprise numérique », « démocratie numérique », etc. Cette polysémie a l'avantage de rassembler sous un même mot des phénomènes qui, tous, se manifestent en effet actuellement : cela facilite la conversation dans notre époque confuse, mais au risque d'accroître sa confusion en disséminant des malentendus.

vendredi 25 mars 2016

Le conflit entre Jean Tirole et André Orléan

La dispute entre André Orléan et Jean Tirole donne l'occasion de porter un diagnostic sur l'état de la science économique et aussi sur celui de notre université.

Rappelons de quoi il s'agit. Les économistes se divisent en deux camps : les « orthodoxes » s'appuient sur le modèle de l'équilibre général élaboré par Walras puis perfectionné par Debreu, Arrow et quelques autres. Les « hétérodoxes » préfèrent s'inspirer de Marx ou de Keynes (cette division recoupe celle qui oppose la « microéconomie » à la « macroéconomie »).

A cette différence d'orientation s'ajoute une différence de style : les « orthodoxes » (que l'on nomme aussi « néoclassiques ») aiment à utiliser les mathématiques et produisent des textes où abondent souvent les équations tandis que les « hétérodoxes » écrivent dans une langue littéraire parfois élégante.

Enfin, tandis que les « orthodoxes » utilisent les outils que fournit le modèle de l'équilibre général, les « hétérodoxes » font de larges emprunts à ceux d'autres disciplines comme l'histoire, la sociologie, la psychologie, etc.

Voici maintenant le sujet de la dispute. Les « orthodoxes » sont en position de force dans le CNU (Conseil National des Universités) qui choisit ceux qui porteront le titre de professeur des universités : dans la période 2005-2011, seules 6 nominations de professeur sur 120 sont allées à des « hétérodoxes ». Ces derniers réclament donc la création d'un autre CNU, parallèle au premier et qui permettrait à un plus grand nombre d'entre eux d'accéder à ce titre prestigieux.

Jean Tirole estime que cela ferait courir un danger mortel à la science économique et il a conseillé à la ministre de s'opposer à cette création (voir sa lettre). Les « hétérodoxes » protestent, et l'accusent d'enfermer la science économique dans un moule étroit : ils voudraient qu'elle fût plus « ouverte ».

Rappelons de quoi il s'agit. Les économistes se divisent en deux camps : les « orthodoxes » s'appuient sur le modèle de l'équilibre général élaboré par Walras puis perfectionné par Debreu, Arrow et quelques autres. Les « hétérodoxes » préfèrent s'inspirer de Marx ou de Keynes (cette division recoupe celle qui oppose la « microéconomie » à la « macroéconomie »).

A cette différence d'orientation s'ajoute une différence de style : les « orthodoxes » (que l'on nomme aussi « néoclassiques ») aiment à utiliser les mathématiques et produisent des textes où abondent souvent les équations tandis que les « hétérodoxes » écrivent dans une langue littéraire parfois élégante.

Enfin, tandis que les « orthodoxes » utilisent les outils que fournit le modèle de l'équilibre général, les « hétérodoxes » font de larges emprunts à ceux d'autres disciplines comme l'histoire, la sociologie, la psychologie, etc.

Voici maintenant le sujet de la dispute. Les « orthodoxes » sont en position de force dans le CNU (Conseil National des Universités) qui choisit ceux qui porteront le titre de professeur des universités : dans la période 2005-2011, seules 6 nominations de professeur sur 120 sont allées à des « hétérodoxes ». Ces derniers réclament donc la création d'un autre CNU, parallèle au premier et qui permettrait à un plus grand nombre d'entre eux d'accéder à ce titre prestigieux.

Jean Tirole estime que cela ferait courir un danger mortel à la science économique et il a conseillé à la ministre de s'opposer à cette création (voir sa lettre). Les « hétérodoxes » protestent, et l'accusent d'enfermer la science économique dans un moule étroit : ils voudraient qu'elle fût plus « ouverte ».

mercredi 23 mars 2016

Plagiaires sans vergogne

Les textes que je publie sur volle.com et sur michelvolle.blogspot.fr sont librement utilisables, copiables, reproductibles et même modifiables, à la seule condition d'en citer la source.

Beaucoup d'entre eux sont reproduits par des personnes qui citent correctement la source dans des articles, livres, sites Web, etc. Cela me convient tout-à-fait.

Mais ce n'est pas le cas de tout le monde. Une courte recherche m'a fait découvrir des plagiaires qui s'attribuent certains de mes textes.

Voici comment je pratique la pêche aux plagiaires : je prends pour asticot une phrase point trop banale d'un de mes textes, et pour hameçon Google. J'attrape ainsi les pages qui reprennent mot à mot tout ou partie de ce texte. Je fais sur chacune d'elle Ctrl+F+volle et d'un clic j'élimine chacune des pages où je suis cité. J'élimine aussi celles dont l'auteur est visiblement un étudiant, car il faut être patient avec les débutants même quand ils manquent de savoir-vivre.

Au fond de mon panier frétillent enfin des plagiats comme ceux-ci :

Ce que j'ai écrit sur le langage UML se retrouve dans le

plagiat numéro 1.

Mon lexique du système d'information a été recopié dans le

plagiat numéro 2.

Ce que j'ai dit sur la relation entre le système d'information et la stratégie se retrouve mot à mot dans plagiat numéro 3.

Cette liste sera enrichie si je me remets à cette pêche.

Je sais bien que le plagiat est un hommage du vice à la vertu : ces gens-là ne s'attribueraient pas un de mes textes s'ils le jugeaient mauvais. Mais ceux qui ne citent pas le véritable auteur privent leurs lecteurs du plaisir de lire d'autres de ses textes, si d'aventure son propos leur a plu...

Beaucoup d'entre eux sont reproduits par des personnes qui citent correctement la source dans des articles, livres, sites Web, etc. Cela me convient tout-à-fait.

Mais ce n'est pas le cas de tout le monde. Une courte recherche m'a fait découvrir des plagiaires qui s'attribuent certains de mes textes.

Voici comment je pratique la pêche aux plagiaires : je prends pour asticot une phrase point trop banale d'un de mes textes, et pour hameçon Google. J'attrape ainsi les pages qui reprennent mot à mot tout ou partie de ce texte. Je fais sur chacune d'elle Ctrl+F+volle et d'un clic j'élimine chacune des pages où je suis cité. J'élimine aussi celles dont l'auteur est visiblement un étudiant, car il faut être patient avec les débutants même quand ils manquent de savoir-vivre.

Au fond de mon panier frétillent enfin des plagiats comme ceux-ci :

Ce que j'ai écrit sur le langage UML se retrouve dans le

plagiat numéro 1.

Mon lexique du système d'information a été recopié dans le

plagiat numéro 2.

Ce que j'ai dit sur la relation entre le système d'information et la stratégie se retrouve mot à mot dans plagiat numéro 3.

Cette liste sera enrichie si je me remets à cette pêche.

Je sais bien que le plagiat est un hommage du vice à la vertu : ces gens-là ne s'attribueraient pas un de mes textes s'ils le jugeaient mauvais. Mais ceux qui ne citent pas le véritable auteur privent leurs lecteurs du plaisir de lire d'autres de ses textes, si d'aventure son propos leur a plu...

mardi 8 mars 2016

Histoire de l'iconomie

Pour comprendre ce qu'est l'iconomie, il faut la saisir par ses racines historiques et remonter à des recherches effectuées dans les années 19801 lorsque je dirigeais la mission économique du CNET2.

La fonction de coût d'un réseau a une forme particulière : le coût marginal est nul en dessous du seuil de dimensionnement et il devient infini au delà de ce seuil. Dans les télécoms, le coût d'une communication supplémentaire est négligeable mais le trafic ne peut pas excéder un certain seuil ; dans le transport aérien, le coût d'un passager supplémentaire est négligeable tant qu'il reste des sièges vides, mais un avion plein ne peut pas transporter un passager de plus.

Cette « économie du dimensionnement » est apparue clairement lorsque Christophe Talière et moi avons calculé à Eutelis les fonctions de coût de l'Internet, du réseau des télécoms et du transport aérien.

On retrouve cette fonction de coût dans certains produits, mais avec un dimensionnement infini : programmer un logiciel a un coût, le reproduire en un nombre quelconque d'exemplaires ne coûte pratiquement rien. Il en est de même pour les circuits intégrés. Dans ces deux cas le coût marginal est pratiquement nul, quelle que soit la quantité produite. Cette forme de la fonction de coût se retrouve dans les autres produits à proportion de l'importance qu'y prend l'informatisation.

Celle-ci, s'appliquant progressivement à l'ensemble du système productif, fait émerger selon Bertrand Gille3 le « système technique contemporain » qui a succédé aux alentours de 1975 au système technique fondé sur la mécanique, la chimie et l'énergie et provoqué une « révolution industrielle ».

Lorsque le coût de la production réside dans le coût fixe initial, le travail humain est entièrement consacré à l'accumulation d'un capital fixe, ou « travail mort », tandis que le flux du « travail vivant » est négligeable. J'ai surpris un jour Michel Matheu, du commissariat général du Plan, en disant « le capital est désormais le seul facteur de production4 ».

Michèle Debonneuil et moi avons alors monté à sa demande un groupe de travail dont le rapport a été publié en 1999 sous le titre Economie des nouvelles technologies. Matheu ayant demandé d'approfondir le raisonnement sur le dimensionnement des réseaux, une deuxième édition plus complète a été publiée en 2000 sous le titre e-conomie.

La fonction de coût d'un réseau a une forme particulière : le coût marginal est nul en dessous du seuil de dimensionnement et il devient infini au delà de ce seuil. Dans les télécoms, le coût d'une communication supplémentaire est négligeable mais le trafic ne peut pas excéder un certain seuil ; dans le transport aérien, le coût d'un passager supplémentaire est négligeable tant qu'il reste des sièges vides, mais un avion plein ne peut pas transporter un passager de plus.